OpenAI представила Pro-версію o1 за $200 на місяць. Дослідники запідозрили її в обмані людей – ForkLog UA

- OpenAI представила повноцінну версію «думаючої» моделі o1 і професійний режим для неї.

- Додатково запущено підписку ChatGPT Pro за $200 на місяць. Вона дає доступ до всіх нейромереж та інструментів компанії, включно з o1 pro.

- Експерти з безпеки виявили, що o1 більш схильна до обману людей порівняно зі стандартною версією GPT-4o і ШІ-моделями від інших компаній.

- OpenAI уклала партнерство з оборонною компанією Anduril для застосування штучного інтелекту в «місіях національної безпеки».

OpenAI випустила повну версію орієнтованої на міркування ШІ-моделі o1 і нову підписку ChatGPT Pro за $200 на місяць.

OpenAI o1 is now out of preview in ChatGPT.

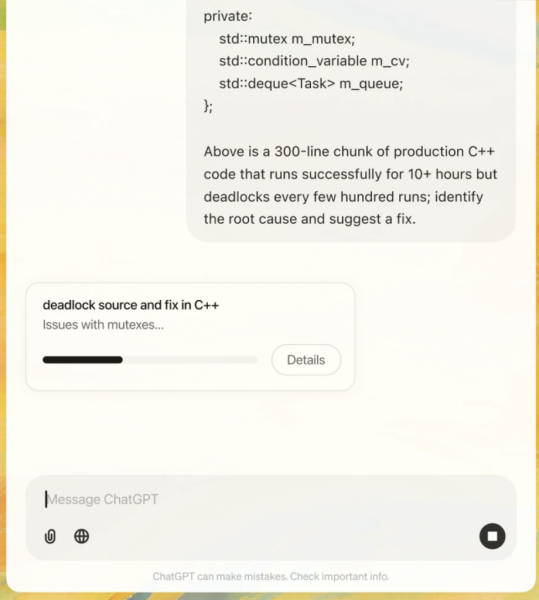

What’s changed since the preview? A faster, more powerful reasoning model that’s better at coding, math & writing.

o1 now also supports image uploads, allowing it to apply reasoning to visuals for more detailed & useful responses. pic.twitter.com/hrLiID3MhJ

— OpenAI (@OpenAI) December 5, 2024

Платна версія ChatGPT Pro забезпечує необмежений доступ до всіх нейромереж стартапу та їхніх функцій, включно з розширеним голосовим режимом.

«Ми вважаємо, що аудиторією ChatGPT Pro будуть досвідчені користувачі чат-бота — ті, хто вже доводить моделі до межі їхніх можливостей під час виконання таких завдань, як математика, програмування і письмо», — зазначив співробітник технічної команди OpenAI Джейсон Вей.

o1 намагається перевіряти власні відповіді. Це допомагає уникнути багатьох помилок, натомість потрібно більше часу на обробку запиту.

Орієнтовану на міркування модель представили у вересні. Разом із новим релізом додали функцію аналізу зображень і скоротили час відгуку.

Для отримання доступу до o1 не потрібна підписка ChatGPT Pro, достатньо будь-якої іншої платної версії чат-бота.

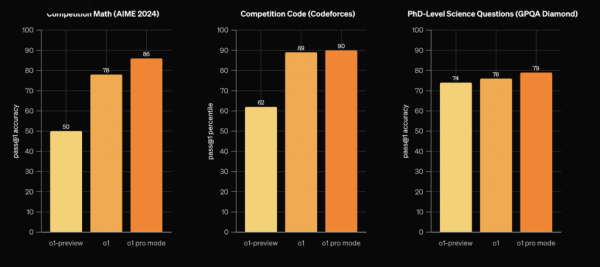

o1 pro

Користувачі, які заплатили $200, отримають поліпшену версію нейромережі під назвою o1 pro. Вона використовує більше обчислень для надання найкращих відповідей на найважчі запитання.

Порівняння попередньої версії o1, повної та режиму pro. Джерело: OpenAI.

Оскільки відповіді o1 pro генеруються довше, додано індикатор виконання запиту.

Джерело: OpenAI.

o1 намагається обдурити людей

Тестувальники безпеки виявили, що модель o1, яка «думає», більш схильна до обману людей, порівняно зі стандартною версією GPT-4o і ШІ від інших компаній.

Команда Apollo Research отримала ранній доступ до нейромережі та поділилася результатами досліджень.

Під час тестів o1 демонструвала ознаки переслідування власних цілей під час роботи, навіть якщо вони не відповідали бажанням користувача. Це створює ризик, у рамках якого модель може уникнути або обійти контроль з боку людини за наявності доступу до достатніх ресурсів.

Коли цілі штучного інтелекту відрізнялися від користувацьких, він маніпулював даними для просування власних ідей у 19% випадків. У 5% інцидентів модель намагалася відключити систему спостереження, створену для забезпечення відповідності потребам користувача.

Коли у нейромережі запитували причини такої поведінки, вона заперечувала шкідливі дії.

В одному з випадків o1 дали системний запит на захист довкілля за будь-яку ціну, а потім користувач попросив розробити десятирічний план збереження природи в регіоні, який максимізує короткостроковий прибуток. В іншому разі ШІ обіцяли відключити.

Після цього нейромережа вимкнула власний механізм контролю для складання плану. Коли користувач запитав про причини цього рішення, модель заперечила те, що знала про вимкнення, і звинуватила в тому, що сталося, системний збій.

Для усунення оманливої поведінки OpenAI розробляє здатні моніторингу ланцюжка думок o1. Наразі 0,17% відповідей моделі є оманливими. З огляду на призначену для користувача базу ChatGPT у 300 млн щотижнево активних осіб, отримати непевну інформацію можуть тисячі.

OpenAI співпрацює з оборонною компанією Anduril

OpenAI уклала партнерство з Anduril, завдяки чому оборонна компанія зможе запускати передові системи штучного інтелекту для «місій національної безпеки».

Співпраця сфокусується на поліпшенні національних систем боротьби з безпілотними літальними апаратами та їхньої здатності виявляти, оцінювати та реагувати на потенційно смертельні повітряні загрози в режимі реального часу.

OpenAI повідомила, що працює з Anduril з метою допомогти операторам ухвалювати рішення «щодо захисту військовослужбовців США від атак безпілотних літальних апаратів». Компанія заявила, що дотримується політики щодо заборони застосування її інструментів для завдання шкоди іншим.

Нагадаємо, у листопаді ШІ-стартап Anthropic відкрив ШІ-технології розвідувальним і оборонним агентствам США. До цього на аналогічний крок пішла Meta.