Apple представила ШІ-модель для зчитування контексту з екрана – ForkLog UA

Дослідники Apple розробили нову ШІ-систему, здатну розуміти контекст.

Згідно з опублікованими документами, функція дає змогу більш природно взаємодіяти з голосовими помічниками.

Система отримала назву Reference Resolution As Language Modeling (ReALM) — «вирішення посилань як моделювання мов». Вона використовує LLM для вирішення проблеми розпізнавання посилань. Це дає змогу ReALM домогтися значного приросту продуктивності порівняно з наявними методами.

«Здатність розуміти контекст, включно з посиланнями, дуже важлива для розмовного асистента. Найважливішим кроком у забезпеченні справжньої свободи рук під час використання голосових помічників є можливість ставити запитання про те, що відображається на екрані», — повідомила команда дослідників Apple.

Для роботи з екранними посиланнями ReALM використовує реконструкцію дисплея за допомогою синтаксичного аналізу об’єктів на ньому та їхнього місця розташування для створення текстового представлення, що передає візуальну схему.

ШІ-модель розроблена спеціально для поліпшення можливостей Siri шляхом врахування даних на дисплеї та поточних завдань. Вона категоризує інформацію на три сутності: екранну, розмовну і фонову.

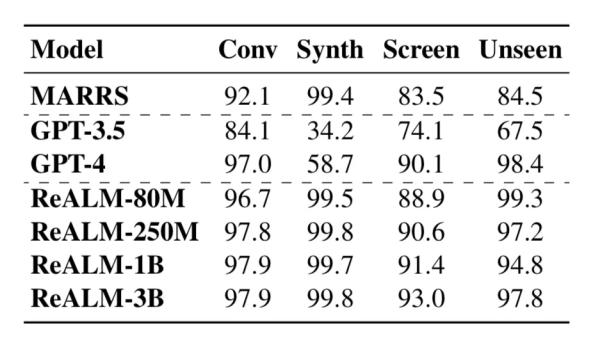

Порівняння ШІ-моделей за ефективністю розпізнавання сутностей. Джерелоі: arxive.org.

Згідно з дослідницькою роботою Apple, ШІ-система не поступається за своїми можливостями GPT-4. Продуктивність найменшої моделі ReALM від Apple можна порівняти з чат-ботом від OpenAI, а більші істотно перевершують його.

Нагадаємо, в лютому CEO Apple Тім Кук розкрив плани корпорації щодо використання генеративного ШІ.